ИИ, который претендует на то, чтобы читать наши чувства, может улучшить пользовательский опыт, но опасения по поводу неправильного использования и предвзятости означают, что эта область чревата потенциальными опасностями.

Сегодня вечер среды, я сижу за кухонным столом, хмуро глядя в ноутбук и изливаю всю желчь, которую могу собрать, в три маленьких слова: «Я люблю тебя».

Мои соседи могут подумать, что я занят мелодраматичным звонком бывшему партнеру или, возможно, каким-то актерским упражнением, но на самом деле я проверяю пределы новой демо-версии от Hume, стартапа из Манхэттена, который утверждает, что разработать «первый в мире голосовой ИИ с эмоциональным интеллектом».

«Мы обучаем большую языковую модель, которая также понимает тон вашего голоса», – говорит генеральный директор и главный научный сотрудник Hume Алан Коуэн. «Это дает возможность… предсказать, как данное речевое высказывание или предложение вызовет определенные эмоции».

Другими словами, Хьюм утверждает, что распознает эмоции в наших голосах (а в другой, закрытой версии – в выражениях лица) и реагирует эмпатически.

Благодаря запуску Open AI нового, более «эмоционального» GPT4o в мае этого года, так называемый эмоциональный ИИ становится все более крупным бизнесом. Hume привлекла 50 миллионов долларов во втором раунде финансирования в марте, и прогнозируется, что в этом году стоимость отрасли достигнет более 50 миллиардов долларов. Но профессор Эндрю Макстей, директор Лаборатории эмоционального искусственного интеллекта в Бангорском университете, предполагает, что такие прогнозы бессмысленны. «Эмоции – это настолько фундаментальное измерение человеческой жизни, что если бы вы могли понимать, оценивать эмоции и реагировать на них естественным образом, это имело бы последствия, которые намного превысят 50 миллиардов долларов», – говорит он.

Возможные применения варьируются от более качественных видеоигр и менее разочаровывающих линий помощи до слежки, достойной Оруэлла, и массовых эмоциональных манипуляций. Но действительно ли ИИ может точно читать наши эмоции, и если какая-то форма этой технологии все равно появится, как нам с ней справиться?

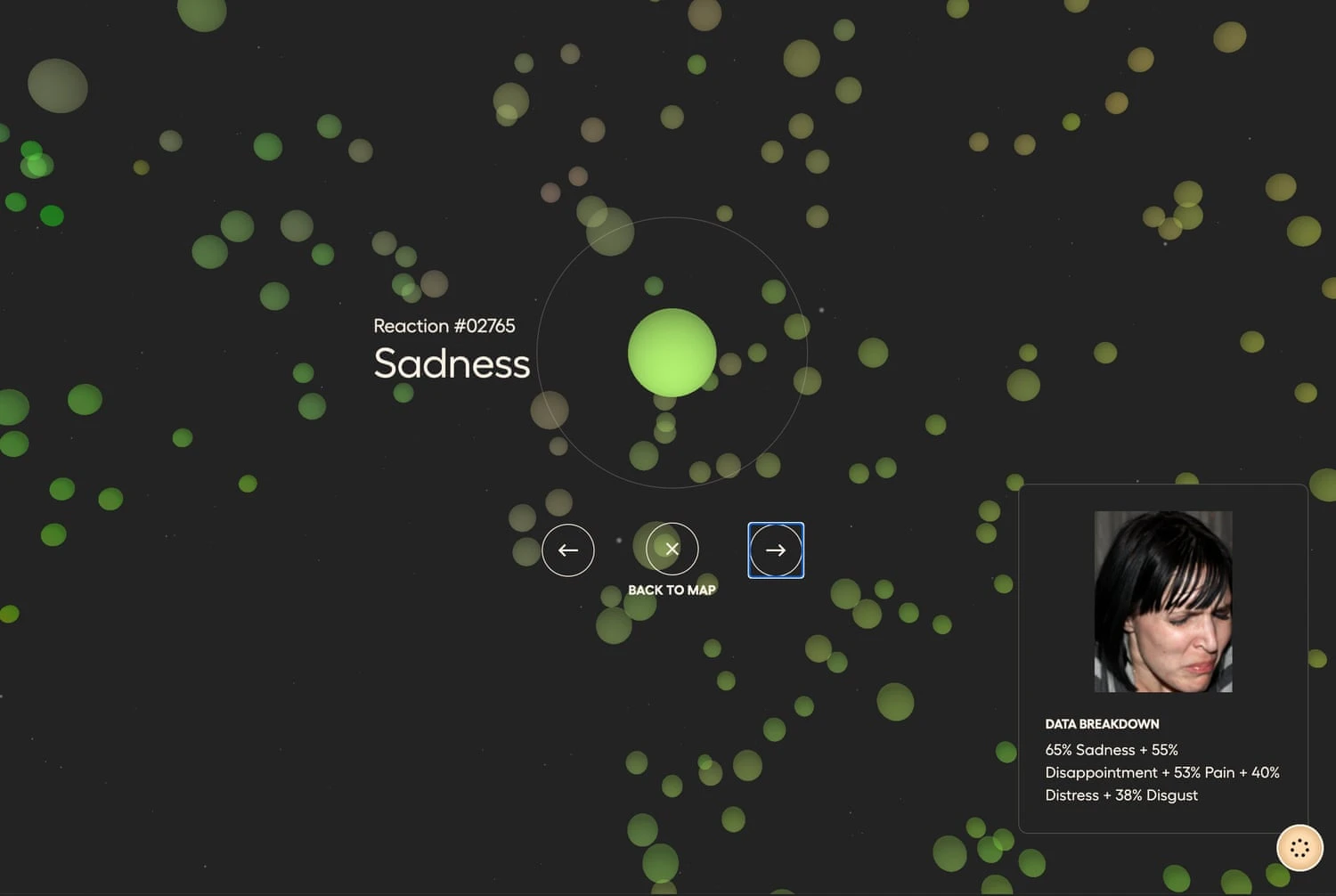

«Я ценю ваши добрые слова, я здесь, чтобы поддержать вас», – отвечает Эмпатический голосовой интерфейс Хьюма (EVI) дружелюбным, почти человеческим голосом, в то время как мое признание в любви появляется в расшифрованном и проанализированном виде на экране. : 1 (из 1) для «любви», 0,642 для «обожания» и 0,601 для «романтики».

Хотя неспособность обнаружить какое-либо негативное чувство может быть связана с плохим поведением с моей стороны, у меня создается впечатление, что моим словам придается больше веса, чем моему тону, и когда я рассказываю об этом Коуэну, он говорит мне, что это тяжело. чтобы модель понимала ситуации, с которыми она раньше не сталкивалась. «Он понимает тон вашего голоса», – говорит он. «Но я не думаю, что когда-либо слышал, чтобы кто-то говорил «Я люблю тебя» таким тоном».

Возможно, нет, но должен ли по-настоящему эмпатический ИИ осознавать, что люди редко держат свое сердце на рукаве? Как однажды заметил Роберт Де Ниро, мастер изображения человеческих эмоций: «Люди не пытаются показать свои чувства, они пытаются их скрыть».

Коуэн говорит, что цель Хьюма состоит только в том, чтобы понять явные выражения лиц людей, и, честно говоря, EVI удивительно отзывчив и натуралистичен, если к нему относиться искренне – но что ИИ будет делать с нашим менее прямолинейным поведением?

Ранее в этом году доцент Мэтт Колер и его команда из лаборатории речевых технологий Университета Гронингена использовали данные американских ситкомов, в том числе «Друзья» и «Теория большого взрыва», для обучения ИИ, способного распознавать сарказм.

Вы можете подумать, что это звучит полезно, и Колер утверждает, что это так. «Когда мы смотрим на то, как машины все больше и больше проникают в человеческую жизнь, – говорит он, – на нас лежит обязанность убедиться, что эти машины действительно могут помочь людям полезным образом».

Колер и его коллеги надеются, что их работа с сарказмом приведет к прогрессу в использовании других лингвистических приемов, включая иронию, преувеличение и вежливость, что обеспечит более естественное и доступное взаимодействие человека и машины, и их начало впечатляет. Модель точно обнаруживает сарказм в 75% случаев, но оставшиеся 25% вызывают вопросы, например: какую лицензию мы должны предоставить машинам, чтобы интерпретировать наши намерения и чувства; и какой степени точности потребует эта лицензия?

Основная проблема эмоционального ИИ заключается в том, что мы не можем точно сказать, что такое эмоции. «Соберите вместе группу психологов, и у вас возникнут фундаментальные разногласия», – говорит Макстей. «Не существует базового, согласованного определения того, что такое эмоция».

Также нет согласия относительно того, как выражаются эмоции. Лиза Фельдман Барретт – профессор психологии Северо-Восточного университета в Бостоне, штат Массачусетс, и в 2019 году она и четверо других ученых объединились с простым вопросом: можем ли мы точно определить эмоции только по движениям лица? «Мы прочитали и обобщили более 1000 статей», – говорит Барретт. «И мы сделали то, чего до сих пор никто не делал: мы пришли к консенсусу относительно того, что говорят данные».

Консенсус? Мы не можем.

«Это очень актуально для эмоционального ИИ», – говорит Барретт. «Потому что большинство компаний, о которых я знаю, все еще обещают, что вы можете посмотреть на лицо и определить, злится ли кто-то, грустит, боится или что-то в этом роде. И это явно не так».

«Эмоционально умный человек обычно не утверждает, что может точно обозначить все, что каждый говорит и говорит вам, что этот человек в настоящее время чувствует на 80% злость, на 18% страх и на 2% грусть», – говорит Эдвард Б. Канг, ассистент. профессор Нью-Йоркского университета, пишущий о пересечении искусственного интеллекта и звука. «На самом деле, для меня это звучит как противоположность тому, что сказал бы эмоционально умный человек».

К этому добавляется пресловутая проблема предвзятости ИИ. «Ваши алгоритмы хороши настолько, насколько хорош учебный материал», – говорит Барретт. «И если ваш учебный материал каким-то образом предвзят, то вы закрепляете эту предвзятость в коде».

Исследования показали, что некоторые эмоциональные ИИ непропорционально приписывают отрицательные эмоции лицам чернокожих людей, что будет иметь очевидные и тревожные последствия, если их использовать в таких областях, как набор персонала, служебная аттестация, медицинская диагностика или полицейская деятельность. «Мы должны вывести [предвзятость ИИ] на первый план в обсуждениях и разработке новых технологий», – говорит Рэнди Уильямс, менеджер программы Лиги алгоритмической справедливости (AJL), организации, которая занимается повышением осведомленности о предвзятости в ИИ.

Итак, есть опасения, что эмоциональный ИИ не работает должным образом, но что, если он работает слишком хорошо?

«Когда у нас есть системы искусственного интеллекта, подключающиеся к самой человеческой части нас самих, существует высокий риск того, что людьми манипулируют ради коммерческой или политической выгоды», – говорит Уильямс, и через четыре года после того, как документы осведомителя раскрыли « В «промышленном масштабе», в котором Cambridge Analytica использовала данные Facebook и психологическое профилирование для манипулирования избирателями, эмоциональный ИИ, похоже, созрел для злоупотреблений.

Как это становится традицией в индустрии искусственного интеллекта, Хьюм назначил членов совета по безопасности – «Инициативы Хьюма», в число членов которого входит генеральный директор. Описывая себя как «некоммерческую деятельность, прокладывающую этический путь для эмпатического ИИ», этические руководящие принципы инициативы включают обширный список «условно поддерживаемых вариантов использования» в таких областях, как искусство и культура, коммуникация, образование и здравоохранение, и гораздо меньший список «неподдерживаемых вариантов использования», в котором упоминаются широкие категории, такие как манипуляция и обман, с несколькими примерами, включая психологическую войну, глубокие фейки и «оптимизацию взаимодействия с пользователем».

«Мы разрешаем разработчикам развертывать свои приложения только в том случае, если они указаны в списке поддерживаемых вариантов использования», – сообщает Коуэн по электронной почте. «Конечно, Инициатива Хьюма приветствует обратную связь и открыта для рассмотрения новых вариантов использования по мере их появления».

Как и в случае со всем искусственным интеллектом, разработка стратегий защиты, которые могут идти в ногу со скоростью развития, является непростой задачей.

Утвержденный в мае 2024 года Закон Европейского Союза об искусственном интеллекте запрещает использование искусственного интеллекта для манипулирования человеческим поведением и запрещает использование технологий распознавания эмоций в таких местах, как рабочие места и школы, но в нем проводится различие между выявлением выражений эмоций (что было бы разрешено) и выводом о эмоциональное состояние человека от них (что не так). Согласно закону, менеджер колл-центра, использующий эмоциональный ИИ для мониторинга, может, возможно, наказать сотрудника, если ИИ скажет, что он говорит сварливо во время звонков, при условии, что из этого не следует, что он на самом деле сварливый. «Честно говоря, любой может использовать такую технологию, не делая явных выводов о внутренних эмоциях человека, и принимать решения, которые могут на них повлиять», – говорит Макстей.

В Великобритании нет специального законодательства, но работа Макстейя с Лабораторией эмоционального искусственного интеллекта помогла определить политическую позицию Управления комиссара по информации, которое в 2022 году предупредило компании избегать «эмоционального анализа» или нести штрафы. , ссылаясь на «псевдонаучный» характер этой области.

Частично предположения о псевдонауке исходят из проблемы попыток извлечь эмоциональную истину из больших наборов данных. «Вы можете провести исследование и найти среднее значение», – объясняет Лиза Фельдман Барретт. «Но если бы вы обратились к любому отдельному человеку в любом индивидуальном исследовании, у него не было бы такого среднего показателя».

Тем не менее, предсказания на основе статистических абстракций не означают, что ИИ не может быть прав, и некоторые виды использования эмоционального ИИ, возможно, могли бы обойти некоторые из этих проблем.

Через неделю после того, как я проверил EVI Юма, у меня состоялся гораздо более искренний разговор с Леннартом Хогманом, доцентом кафедры психологии Стокгольмского университета. Хогман рассказывает мне об удовольствиях воспитания двух своих сыновей, затем я описываю особенно хороший день из моего детства, и как только мы поделились этими счастливыми воспоминаниями, он передает видео с нашего звонка Zoom в программное обеспечение, которое его команда разработала для анализируйте эмоции людей в тандеме. «Мы изучаем взаимодействие», – говорит он. «Таким образом, это не один человек что-то показывает, это два человека, взаимодействующие в определенном контексте, например, в психотерапии».

Хогман предполагает, что программное обеспечение, которое частично основано на анализе выражений лица, может использоваться для отслеживания эмоций пациента с течением времени и станет полезным инструментом для терапевтов, чьи услуги все чаще предоставляются онлайн, помогая определять прогресс лечения, выявлять стойкие реакции на определенные темы и следить за согласованностью действий между пациентом и терапевтом. «Доказано, что альянс является, пожалуй, самым важным фактором в психотерапии», – говорит Хогман.

Хотя программа анализирует наш разговор кадр за кадром, Хогман подчеркивает, что она все еще находится в разработке, но результаты интригуют. Просматривая видео и сопровождающие его графики, мы видим моменты, когда наши эмоции явно совпадают, когда мы копируем язык тела друг друга и даже когда один из нас кажется более доминирующим в разговоре.

Подобные идеи могли бы смазать колеса бизнеса, дипломатии и даже творческого мышления. Команда Хогмана проводит еще не опубликованное исследование, которое предполагает наличие корреляции между эмоциональной синхронизацией и успешным сотрудничеством при решении творческих задач. Но неизбежно остается место для злоупотреблений. «Когда обе стороны в переговорах имеют доступ к инструментам анализа ИИ, динамика, несомненно, меняется», – объясняет Хогман. «Преимущества ИИ могут быть сведены на нет по мере того, как каждая сторона станет более изощренной в своих стратегиях».

Как и в случае с любой новой технологией, влияние эмоционального ИИ в конечном итоге будет зависеть от намерений тех, кто им управляет. Как объясняет Рэнди Уильямс из AJL: «Чтобы успешно принять эти системы как общество, мы должны понять, как интересы пользователей не совпадают с интересами институтов, создающих технологию».

Пока мы этого не сделаем и не начнем действовать в соответствии с этим, эмоциональный ИИ, скорее всего, будет вызывать смешанные чувства.